微信掃碼咨詢

來源:硬AI

OpenAI的Sora迎來勁敵,Meta推出號稱最先進的媒體基礎模型Movie Gen。

Meta稱,Movie Gen是公司“針對媒體的突破性生成式AI研究”,它囊括了圖像、視頻和音頻等模態,用戶只需輸入文本,就可以制作自定義的視頻和聲音、編輯現有視頻,以及將個人圖像轉換為獨特的視頻。Movie Gen執行這些任務的表現在人類評估中由于業內類似模型。

Meta介紹,Movie Gen是“最先進、沉浸式效果最佳的故事講述模型套件”,綜合了公司第一波生成式AI媒體研究的Make-A-Scene 系列模型,即可創建圖像、音頻、視頻和 3D 動畫的模型,以及隨著擴散模型出現而針對Llama Image 基礎模型進行的第二波研究模型,即可實現更高質量圖像和視頻生成以及圖像編輯的模型。

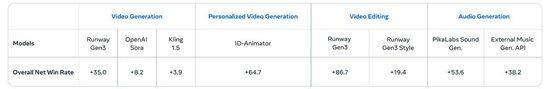

文生視頻最長16秒 130億參數音頻生成模型 人工評測視頻生成對Sora凈勝率8.2

Meta概括,Movie Gen 具有四種功能:視頻生成、個性化視頻生成、精確視頻編輯、音頻生成。

對于視頻生成,Meta介紹,用戶只要提供一個文本的提示詞,Movie Gen就可以利用針對文本轉圖像和文本轉視頻進行了優化的聯合模型,創建高清的高質量圖像和視頻。Movie Gen的視頻模型有300億參數,這個轉換模型能以每秒16幀的速度生成最長16秒的視頻。

Meta稱,發現這些模型可以推理物體的運動、拍攝主體與物體之間的相互作用,以及相機的運動,并且可以學習各種概念了解有哪些合理的運動,因此,它們成為同類中最先進的模型。在介紹該功能時,Meta展示了多個10秒長度的視頻短片,包括一只像萌翻網絡的彈跳豬“Moo Deng”那樣的小河馬游來游去。

華爾街見聞注意到,單從生成視頻的最大長度看,Movie Gen還不敵今年2月OpenAI發布的Sora。Sora令業界震撼的一點是,可以創建長達60秒的文生視頻,。不過,相比Meta去年11月官宣的視頻模型Emu Video,Movie Gen確實進步不小。Emu Video只能以每秒16幀的速度生成最長4秒的視頻。

除了直接文生視頻,Movie Gen還有出色的個性化視頻制作能力。Meta介紹,其擴展了前述基礎模型,支持生成個性化視頻。用戶可以提供某個人的圖像,配合文本的提示詞,讓Move Gen生成的視頻包含參考圖像中的人物,以及符合文本提示的視覺細節。Meta稱,在創建保留人類身份和動作的個性化視頻方面,其模型取得了最先進的成果。

Meta展示的一個視頻顯示,用戶可以提供一個女孩的照片,輸入文字“一名身穿粉色馬甲的女DJ播放唱片,她身旁有一只獵豹”,然后就生成了以照片中女孩形象的DJ打碟,以及一只獵豹陪伴。

在精確視頻編輯方面,Meta稱,Movie Gen采用了同一基礎模型的編輯變體模型,在用戶輸入視頻和文本提示詞后,精確執行任務,生成所需的輸出。它將視頻生成與高級圖像編輯相結合,執行局部編輯,例如添加、刪除或替換元素,以及諸如背景或樣式修改的全局更改。與需要專業技能或缺乏生成精確度的傳統工具不同,Movie Gen 保留了原始內容,僅針對相關像素編輯。

Meta提供的示例之一是,用戶輸入,讓企鵝穿上有英國女王維多利亞在位時期服飾風格的服裝,Movie Gen生成的企鵝穿上了帶蕾絲的紅色女裙。

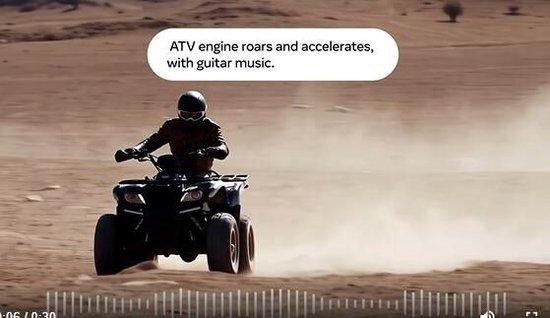

對于音頻生成,Meta稱,訓練了一個130億參數的音頻生成模型,該模型可以接受視頻和可選的文本提示詞,生成長達 45 秒的高質量高保真音頻,包括環境音、擬聲音效(Foley)和樂器背景音樂,所有這些都與視頻內容同步。此外,Meta引入了一種音頻擴展技術,可以為任意長度的視頻生成連貫的音頻,在音頻質量、視頻到音頻對齊和文本到音頻對齊方面總體上實現了最先進的性能。

Meta提供的一個例子是,生成在吉他音樂的伴奏下,全地形車(ATV)引擎轟鳴加速的聲音,還有一個例子是,管弦樂聲中有樹葉沙沙作響和樹枝折斷的聲音。

Meta還展示了針對以上四種能力進行的A/B對比測試人工評估結果,下圖顯示的凈正值勝率代表,相比Sora等競品模型,人類評估者更青睞Movie Gen模型生成的結果。在直接生成視頻這個功能方面,Movie Gen相比Sora的凈勝率達到8.2。

基于授權和公開可用數據訓練 未明確何時發布 扎克伯格稱明年上線Instagram

Movie Gen 是基于哪些信息進行訓練的?Meta 的聲明沒有說明具體細節,只是說:“我們基于授權和公開可用的數據集對這些模型進行了訓練。”

有評論指出,對生成式 AI 工具而言,訓練數據的來源以及從網上抓取哪些數據合理仍然是有爭議的問題,而且公眾很少知道使用哪些文本、視頻或音頻片段創建了任何大模型。

還有評論稱,Meta說訓練用的數據集是“專有/商業敏感”的,未提供細節,那么只能猜測,數據包括很多Instagram 和 Facebook 平臺的視頻,加上一些Meta合作伙伴的內容,以及其他很多未得到充分保護的內容、也就是所謂的“公開可用”內容。

對于發布時間,Meta本周五并未明確Movie Gen何時面向大眾推出,只是含糊地說“可能未來發布”。今年2月OpenAI官宣Sora后迄今還未真正向公眾開放使用,也并未透露任何計劃將要發布的日期。

不過,Meta CEO扎克伯格稱,Movie Gen明年會上線Meta旗下的社交媒體Instagram。他在個人Instagram賬號發布了一段Movie Gen生成的視頻,顯示他在用腿部推舉機,隨著他開始鍛煉,背景發生了變化。先是顯示,他在一家霓虹燈照耀的未來風格健身房鍛煉,然后變為,他穿著角斗士盔甲鍛煉,接著變為他推動一臺燃燒的純金機器,最后變為,他用腿部推舉一盒雞塊,周圍是一片薯條。

扎克伯格配上文字稱,Meta新的 Movie Gen AI 模型可以制作和編輯視頻,每天都是煉腿的日子。該模型將于明年登陸 Instagram。

在社交媒體X,Meta官宣并演示Movie Gen的帖子下面,一些點贊高的評論顯示,網友已經在催促Meta正式發布該模型,有網友問,不知道大家有沒有機會來試試它。

風險提示及免責條款

市場有風險,投資需謹慎。本文不構成個人投資建議,也未考慮到個別用戶特殊的投資目標、財務狀況或需要。用戶應考慮本文中的任何意見、觀點或結論是否符合其特定狀況。據此投資,責任自負。

13560189272

13560189272  地址:廣州市天河區黃埔大道西201號金澤大廈808室

地址:廣州市天河區黃埔大道西201號金澤大廈808室